年更文来啦,2025年的合集——

今年因为有了更好的AI,做了更多事情。可以称为Agent元年了,助手们都升级成了Agent:ChatGPT、Gemini+NotebookLM、Claude Code、Manus。

今年,做了近30个大大小小的demo,去复现、去学习、去思考创新。

今年,写了52期AI大模型动态周报,完成了又一年的AI编年史。

1月

2025-01-02 13:05:12

芒果tv app竟然没有湖南卫视直播

2025-01-05 14:09:01

闪念胶囊AI版

2025-01-07 18:58:57

Time Machine用移动硬盘,就老是要忘记备份

2025-01-08 11:32:51

飞书的会议后智能纪要和近期会议总结,完全就是AI秘书了,秒杀实习生……

2025-01-10 14:29:31

微信啥时候能支持会话分组啊,现在要变相实现的话只能把工作群全丢到折叠的群聊里

2025-01-11 09:43:03

ICS、纪实人文、七彩戏剧三个频道停播,在东方有线和电信IPTV被直接跳过,看看新闻把ICS直播替换为了ShanghaiEye,纪实人文替换为了新纪实(轮播东方卫视制作的纪录片)

2025-01-11 21:21:42

飞机两个黑匣子数据可以实时流式传输到服务器备份,航班执行完成后则删除

2025-01-11 21:25:05

五星体育广播、KFM981、浦江之声广播三套广播频率停播

2025-01-12 13:22:50

#nowplaying 许卿安 – 周深

2025-01-13 09:51:19

摸鱼神器:https://iwoso.co/hotnews

2025-01-14 16:39:47

Ollama几乎可以让任何8GB及以上内存的PC变成AI PC

2025-01-19 00:40:56

凌晨12点的宝安机场就跟晚高峰一样🤪

2025-01-19 00:43:22

原来开启了面容锁的app,桌面小组件也会被删掉/无法添加(合理但好像少了提示

2025-01-20 01:00:46

有人在小红书评论区写了一句hack prompt,大模型翻译时遵循了这句prompt😂

2025-01-21 19:57:47

今天热到什么程度呢?就是在餐厅吃饭脱了外套,然后走的时候走出来很远了,都没有发现外套忘了带。

2025-01-24 14:23:40

ChatGPT Operator的演示中用到的服务都是web的(browser use),湾区生活中的主流服务,包括opentable、instacart、stubhub、thumbtack、doordash,没有演示跨服务的操作。

2025-01-24 14:28:57

https://www.youtube.com/watch?v=CSE77wAdDLg

2025-01-26 12:57:28

DeepSeek-R1已经被Ollama放在首页第二位推荐了

2025-01-26 13:19:33

DeepSeek官方线上版本比开源的效果好,本地跑的7b的版本我觉得不如qwen2.5,可能要更大参数,但我设备性能不够了

2025-01-27 18:15:06

过年期间亲戚聊天内容来自大家平时刷的短视频😳

2025-01-28 23:53:03

春晚直播信号版本:高清、超高清HDR、竖屏、听觉无障碍、视觉无障碍、CGTN版

春晚视频号:竖屏+后台

春晚小红书:大家的春晚

2025-01-30 16:08:39

过年期间给不方便科学上网的朋友按头安利了DeepSeek

2月

2025-02-01 09:33:32

测试了两道此前仅有r1和o1做对的数学题,免费的o3-mini都做对了,且推理速度和输出速度极快!真卷啊

2025-02-02 07:39:41

siliconflow在华为昇腾芯片的集群上部署了deepseek-r1推理服务!

2025-02-03 10:38:28

https://www.setn.com/News.aspx?NewsID=1603533

2025-02-03 12:46:16

在飞机上读paper,配合本地LLM可以轻松翻译加查询讨论

2025-02-03 14:56:00

sam altman正在东京跟孙正义对谈。今天早上OpenAI宣布的Deep Research也是在东京办公室发布的。

2025-02-05 14:20:53

除了openwebui,Enchanted客户端是mac上最好的ollama UI

2025-02-06 17:11:12

16G内存的mbp,本地部署ds有两种方案:

1、Ollama + deepseek-r1:14b + chat app,chat app推荐CherryStudio

2、LM Studio + deepseek-r1:7b去审查版gguf模型

2025-02-06 23:24:06

哪吒2的第一出品方是成都的公司,导演也是四川人

2025-02-07 08:49:42

GTA6今秋发布 https://a.jump-game.com/wapp/p/537313

2025-02-07 14:18:46

看完哪吒2,想起《十万个冷笑话》,又翻出来看了一遍,真是经典啊 https://www.bilibili.com/bangumi/play/ep12087/

2025-02-09 11:28:48

微博b站抖音毛象都能多点登录,小红书还不能

2025-02-09 15:18:06

Deepsex 离谱 https://huggingface.co/spaces/ValueFX9507/Tifa-Deepsex-Cot-14B

2025-02-10 14:41:05

双流T1翻新完毕,2月24日恢复运营,成都再次回到两场4航站楼1卫星厅

2025-02-10 14:43:08

https://unsloth.ai/blog/r1-reasoning

2025-02-11 11:59:02

https://www.bbc.com/zhongwen/articles/cgmyp4dpykzo/simp

2025-02-12 18:27:13

huggingface上这么多model的下载量,带宽得多大。。

2025-02-12 19:07:59

https://www.bilibili.com/video/BV1bnNDeFELK/

https://www.xiaoyuzhoufm.com/episode/67a1b697247d51713c868367

2025-02-13 19:11:36

哪吒2突破百亿票房

2025-02-13 22:14:31

【大神Andrej Karpathy最新讲座:深入探讨ChatGPT类大语言模型-哔哩哔哩】 https://b23.tv/pjyRR5g

2025-02-16 21:11:49

GPT-4.5、Claude4、Grok-3都快来了

2025-02-17 09:54:01

大部分伸手党已经会用AI搜索了

2025-02-17 09:55:07

网球初体验:因为乒乓球和羽毛球的思维惯性,老是接球发力和打高球。

2025-02-17 12:14:14

两周过去了,DeepSeek-R1-671b在ollama上的两个量化版本,Q2.51/Q1.58,都超过了5万下载量。也就是说有超过10万台192GB以上内存的设备都部署了满血版。

2025-02-24 08:41:21

https://anyvoice.net/zh/ai-voice-cloning

2025-02-24 10:49:37

俄乌战争三周年。

2025-02-24 20:55:35

Claude 3.7 Sonnet 是 Anthropic 迄今最聪明的模型,也是首个能进行“扩展思考”的 Claude 模型。

2025-02-26 10:11:51

特斯拉FSD就这么突然的在国内推送了,V13.2.6版本。

官方更新公告中称为“城市道路Autopilot”。此前已购买FSD且为HW4的焕新3和model s/x plaid已经收到2024.45.32.12推送。

目前看起来跟北美的纯视觉端到端版本是一样的,并未针对中国道路做训练,无法识别实线、待转区和部分掉头车道。

2025-02-26 10:49:52

本次更新恰好在春节EAP赠送到期和焕新Y开启交付的时间。焕新Y应该交付即可支持。

马斯克称特斯拉使用了公开可用的中国道路和交通标志视频,通过创新的视频模拟环境对FSD进行了训练。

2025-02-27 10:05:53

在人工智能逐步替代标准化工作的趋势下,”长尾工作”正成为人类保持经济价值的核心领域。这些需要复杂认知、情感互动和创造力的工作类型,构成了未来人类就业的护城河。

2025-02-27 15:55:03

回看o1-preview刚发布时的推理过程reasoning_content,是分要点展示的

https://www.techradar.com/computing/artificial-intelligence/chatgpt-o1-preview-can-solve-riddles-faster-than-me-and-i-kind-of-hate-it-for-it

3月

2025-03-05 19:43:26

iOS18.4 已经可以显示5Ga的信号了

2025-03-06 11:43:21

https://mcp.composio.dev/

2025-03-07 19:28:34

Manus用到的模型是Claude和微调后的Qwen

2025-03-08 17:16:08

看《猫猫的奇幻漂流》像在玩《stray迷失》

2025-03-09 00:58:46

难哄 虽然剧情槽点很多,但台湾导演的拍摄风格、剪辑、视觉都不错,每首ost音乐也很棒,是一部质量很好的纯爱剧。

2025-03-10 18:26:34

modelscope的模型上传流程,跟huggingface差了两条街

2025-03-11 01:03:34

ImageNet数据集与竞赛开启了深度学习浪潮之后,每个时代都有自己的当红榜单指引着最前沿技术的发展:

BERT时代是语言理解基准CLUE、SpuerCLUE。

随后ChatGPT、Claude、Gemini已经刷爆了考验各学科知识的MMLU、以及用户盲选投票的LLM Arena大模型竞技场。

o1/r1/QwQ类推理模型正在比拼数学(AIME、FrontierMath)、博士级别理科题(GPQA)、编程/软件工程能力(Codeforces、SWE-bench、LiveCodeBench)。

而智能体刷GAIA,似乎正在成为行业最新共识。

2025-03-11 15:46:29

火山引擎开源的这些AI应用 质量都不低

https://www.volcengine.com/product/ai-app-lab

2025-03-13 17:54:19

自此,美国芯片企业中,英特尔CEO陈立武、英伟达创始人兼CEO黄仁勋、AMD董事长兼CEO苏姿丰、博通总裁兼CEO陈福阳、MPS芯源系统创始人兼CEO邢正人、安霸总裁兼CEO王奉民等,均为华人。

(三个台湾,两个马来西亚,一个大陆

2025-03-16 20:39:51

塞尔吉尼奥在国足队内跟蒋光太粘在一起嘛

2025-03-17 01:20:31

VOA因为川普的行政令都停播了

2025-03-17 11:15:39

https://lookup.icann.org/zh

RDAP查询工具(新版WHOIS)

2025-03-17 17:02:08

Grok和Gemini的深度研究都还挺好用的

2025-03-17 19:05:40

FSD在中国大陆开启一个月免费体验活动,将推送给所有符合条件的车辆(目前尚不确定是否包含HW4以下的车辆)

2025-03-18 11:15:28

Manus也是一种自动驾驶。

2025-03-18 19:00:58

我的第一个Manus case回放: https://manus.im/share/xBetXI2KjAJhq6FybgOqP4?replay=1

2025-03-20 22:26:48

春分+国际幸福日

2025-03-21 09:19:56

小红书什么时候能多设备同时登录啊🥲

2025-03-21 09:32:03

2024年上海的冬天过去了。2024.11.20-2024.3.20

2025-03-21 11:55:11

意大利报纸《IL Foglio》推出全球首份完全由AI生成的实体报纸,从写作到讽刺手法皆出自AI之手。《IL Foglio》的编辑Claudio Cerasa称,这次发行AI报纸,是一项为期一个月的新闻实验的重要部分,旨在全方位展示AI技术对工作方式以及日常生活的影响。

2025-03-21 17:42:14

计算机历史博物馆收藏了2012年的AlexNet的源码,AlexNet的开发者包括Geoffrey Hinton、Ilya Sutskever和Alex Krizhevsky

https://github.com/computerhistory/AlexNet-Source-Code

2025-03-23 18:27:41

“穷人的焦虑来自于没钱,富人的焦虑来自于都得死。富人的松弛感来源于有钱,穷人的松弛感来源于都得死。”

2025-03-23 18:55:43

《联合早报》:中国特稿:中共二十大下半场 盘点政治新星行情

https://www.zaobao.com/news/china/story20250323-6048835

2025-03-23 20:56:06

Google退出中国市场15周年。

2025-03-24 13:56:21

RWA 是指可以在区块链上进行代币发行、交易或管理的传统物理或金融资产。一旦有了RWA通证之后,就可以用来做很多DeFi资产管理,这类资产包括房地产、商品、股票、债券、应收账款、知识产权等。通过区块链技术将这些现实世界的资产进行代币化,使它们可以数字形式进行交易和管理,从而提高流动性和透明度。

2025-03-24 18:41:49

flowith oracle模式生成的网站合集:https://flowithai.feishu.cn/docx/I5J6dQZt9opp2Rxhdi2c0JnrnKc

2025-03-25 09:57:43

todesk减少免费版用户每月连接次数了

2025-03-26 14:46:10

ai.dev域名指向Google AI Studio

2025-03-26 16:54:28

trae对普及AI编程的贡献会比cursor更大

2025-03-26 20:07:04

Claude太适合写nextjs项目了,搭配github+vercel+supabase,发布小型web应用太方便了

2025-03-27 22:18:46

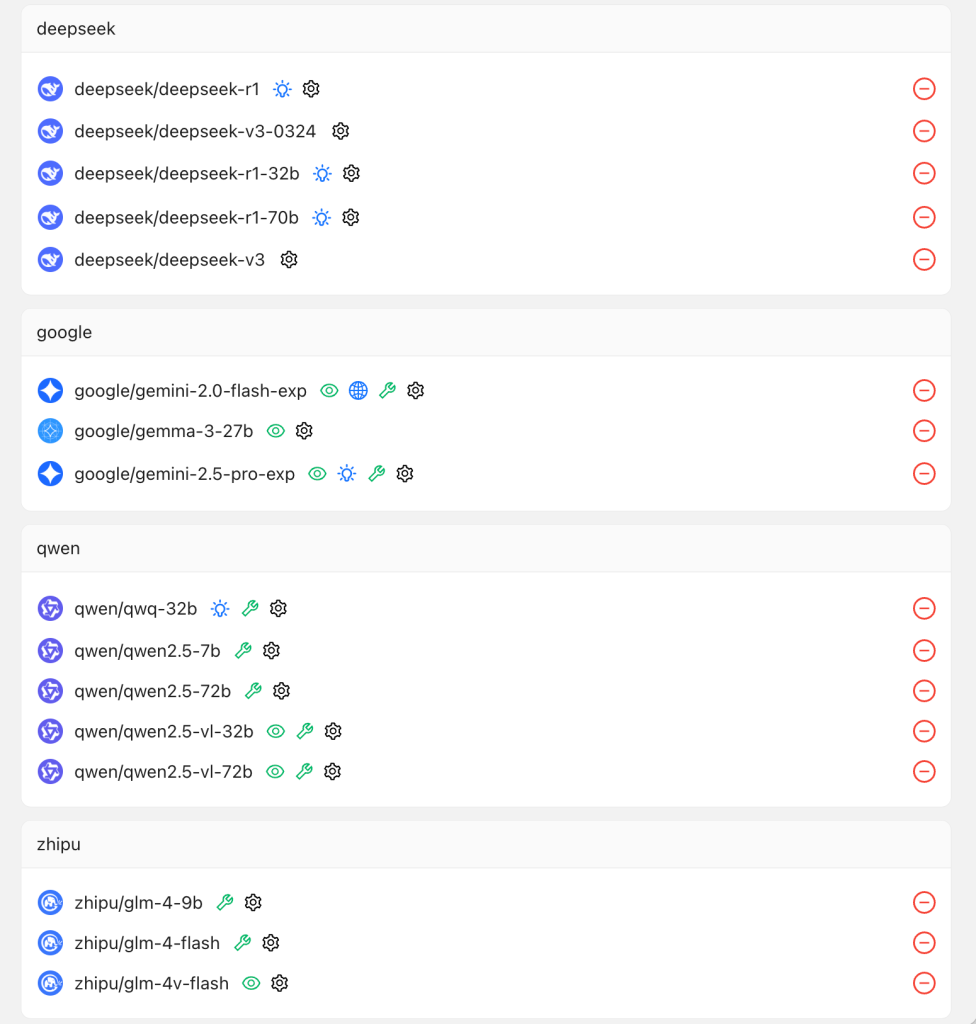

用trae做了一个免费LLM API服务,技术栈:nextjs+vercel+supabase

platform.aitools.cfd

由于3.7一直排队,编码+debug都由Claude-3.5-Sonnet模型完成

2025-03-28 11:06:00

mac微信4.0.3.50彻底重构了,聊天记录都要迁移一遍 :0010:

2025-03-28 13:08:50

https://stcn.com/article/detail/1609852.html

2025-03-28 14:54:30

云族裔发售了,画面好逼真啊

2025-03-28 17:51:19

https://x.com/PJaccetturo/status/1905151190872309907

效果太好了

4月

2025-04-02 10:30:39

虽然都叫自动驾驶,但实际的技术可能差很远,高精地图+hard code和大模型端到端可以说从原理上有根本的不同,这也是为什么fsdv12和v13差距这么大。

施工路段NOA时速97=不要命。

2025-04-02 16:10:36

https://firstpagesage.com/seo-blog/the-google-algorithm-ranking-factors/

2025-04-05 14:08:53

微软50周年,盖茨在博客撰文:https://www.gatesnotes.com/meet-bill/source-code/reader/microsoft-original-source-code

2025-04-06 00:34:08

https://www.youtube.com/watch?v=AhhQ3e8Re1k

2025-04-07 22:06:26

https://zh.wikipedia.org/wiki/%E4%B8%8A%E6%B5%B7%E6%8A%A5%E7%BA%B8%E5%88%97%E8%A1%A8

现时上海仍有79份报纸在出版

2025-04-09 12:29:36

https://next-hackathon-2025.vercel.app/

2025-04-09 14:18:30

https://cn.nytimes.com/china/20250409/china-trump-tariffs/

2025-04-11 10:33:39

Google搜索框变长了

2025-04-12 14:33:50

大风来了💨

2025-04-14 09:56:53

周末想做一个东西,刚才上班路上跟deepseek-v3-0324讨论好了技术方案 :0000:

2025-04-14 13:16:31

https://xhslink.com/iNYicab

2025-04-14 20:47:27

纸上得来终觉浅,绝知此事要躬行。

2025-04-15 20:33:45

寄蜉蝣于天地,渺沧海之一粟。哀吾生之须臾,羡长江之无穷。

2025-04-17 11:02:47

有人说微信现在成了最大的AI应用,但是元宝账号又不是所有用户默认关注的,并且目前也还没有上任何与微信个人数据结合的扩展功能。

2025-04-17 12:15:14

o3已经是agent了,会搜索、执行代码、理解图片等操作组合完成任务

2025-04-21 16:50:14

ChatGPT已经可以自动判断当前问题是否需要搜索最新信息后回答了。

2025-04-22 22:26:54

瑞哥火到国外了

2025-04-23 15:39:44

少看社交媒体,多看书

2025-04-24 21:10:51

清理mac微信旧版本数据,腾出接近100GB空间 :0000:

2025-04-29 08:39:36

Qwen3的混合推理,简单问题不think,复杂问题才think。还可以手动控制,加/no_think 或/think

5月

2025-05-04 10:19:59

nike run club美区重装后用海外ip可登回原账号

2025-05-05 20:03:33

今天开ap走高架路,自动绕开了一段积水路段,第一次遇到。

2025-05-09 16:57:29

gemini的veo2生成视频的效果太好了

2025-05-11 12:05:52

快递因为都直接放驿站 所以现在买东西都宁愿选择外卖/即时配送了

2025-05-11 13:16:09

目前mcp server的鲁棒性太差

2025-05-12 11:14:41

web.skype.com已跳转到teams.live.com

2025-05-13 13:46:57

鸿蒙PC的一些细节:

-华为原来销售的所有笔记本设备都无法升级到鸿蒙PC系统

-目前两个虚拟机软件:鸿云虚拟桌面(云电脑)、Oseasy虚拟机(可安装Arm Win系统)

-可添加打印机和扫描仪

-type-C口可外接显示器,HDMI转接头也可以使用

2025-05-14 13:58:13

AI从工具逻辑转向交付成果逻辑

2025-05-15 10:17:39

NotebookLM的命名跟ChatGPT如出一辙。

2025-05-15 21:28:29

心情很down

2025-05-16 08:50:49

鸿蒙PC即将发布一款折叠屏电脑……

2025-05-16 11:48:10

天地图的api做得不错

2025-05-19 00:02:30

vibe coding时你会发现模型引入的package都是老版本,这个服务提供的上下文可以帮助模型知道当前最新版本:https://context7.com/

2025-05-20 16:46:06

不同的任务散落在ChatGPT、Claude、DeepSeek、Manus、Cursor、CherryStudio、OpenWebUI里,难找

2025-05-21 14:39:02

Flow TV (随机观看使用Google Flow filmmaker生成的视频)

https://labs.google/flow/tv

2025-05-21 15:37:38

https://stitch.withgoogle.com/

UI设计

2025-05-21 18:31:45

小满。

2025-05-22 23:46:15

veo 3的作品简直难辨真假

2025-05-23 00:54:17

https://www.youtube.com/watch?v=EvtPBaaykdo

2025-05-26 19:31:42

才开始听tank去年手术前完成的专辑《我不伟大 至少我能改变我》

2025-05-29 01:29:27

洗完头自然干+睡觉起来,自动空气刘海,比吹的还好一点😂

2025-05-30 18:25:38

中国的AI大模型还是得靠开源,在国际上获得影响力。DeepSeek、Qwen、Hunyuan

6月

2025-06-01 18:19:58

国铁上海东的官方名称叫“东方枢纽上海东站”

2025-06-03 10:47:30

iOS用年份命名,iPhone应该不会

2025-06-04 11:22:34

Claude自己写的博客:https://www.anthropic.com/claude-explains

2025-06-06 21:00:50

OpenAI和Anthropic的官方文档都提供了一键copy page的功能,便于开发者快速把文档复制发给AI作为上下文。

2025-06-08 14:20:22

HDC25要发布HarmonyOS6了😂

2025-06-08 19:46:18

最近对投放的理解更深入了

2025-06-13 11:11:54

上影节开始了

2025-06-15 11:21:31

https://developer.mozilla.org/zh-CN/docs/Web/HTTP

2025-06-15 11:28:57

原来斗内是donate的音译

2025-06-16 16:53:39

Manus的UI和交互,果然影响了后来的Agent产品

2025-06-17 14:07:55

国内的AI六小龙已经变成四小龙了

2025-06-20 14:09:34

As an Early Access rider, you can be among the first to use our new Robotaxi App and experience an autonomous ride within our geofenced area in Austin. Through this exclusive preview, you’ll have the opportunity to provide valuable feedback on our Robotaxi service.

2025-06-22 00:59:34

基座大模型公司,现在差不多2-3个月迭代一次模型能力,否则就跟不上对手的速度,渐渐淘汰。

2025-06-24 14:00:36

柴静发了视频之后,新闻调查停播了?6月7号之后,连续两期没播了

2025-06-25 15:13:05

SpecStory插件(VSCode/Cursor),可以快速将与AI的对话历史保存为markdown

2025-06-26 15:22:18

vercel, cloudflare, supabase, google ai studio都是大善人

2025-06-27 14:09:59

现在电脑买来,本地模型要占掉50GB左右

2025-06-29 14:36:39

我好像天生更对开放开源有好感,开始用Void替代Cursor,虽然还不能完全替代,但基本功能可以了

7月

2025-07-02 00:07:00

Apple Music都十年了啊

2025-07-02 08:39:23

听到蝉鸣了。

2025-07-09 09:59:19

以前:收u

现在:稳定币收款

2025-07-11 11:47:00

macOS上对图片右键-快速操作-转换图像,即可快速压缩图片大小

2025-07-13 11:50:35

国内的开源大模型几乎都会兼容华为昇腾910B的推理了

2025-07-14 23:39:51

Moonshot 团队在社交平台上给出明确答复:Kimi K2的架构确实完全继承自 DeepSeek V3。他们团队曾尝试多种不同于DeepSeek V3的MoE/Dense结构变种,但始终没有任何设计在 loss 上显著超过 DeepSeek V3。为了在已经面临优化器和大规模参数这两大变量下避免引入更多不确定性,团队选择了一个务实的策略:完全继承DeepSeek V3的底层架构。

2025-07-15 20:45:32

Grok的Ani有点油腻

2025-07-16 18:54:43

@thepaper 政治正确大师

2025-07-17 10:28:46

荣威i6 max专晒乘客……

2025-07-18 16:10:35

徐正源与蓉城的纠纷,之前传言已久,没想到竟然是真的。徐师在蓉城球迷心中有极高的声望,可谓功勋教练。

2025-07-19 12:48:12

美国创新,中国复制,欧洲监管

2025-07-21 13:36:01

港美股的年度收益,要交20%的税了

2025-07-23 15:47:44

Trae的SOLO模式竟然可以在同一个项目下实现与IDE模式秒切换界面,妙啊

2025-07-23 15:54:43

今天体验的新产品:trae solo模式、qwen code with qwen3-coder、trickle.so、zread.ai、codebuddy IDE

2025-07-25 20:31:00

上海进入WAIC时间~

2025-07-29 21:24:50

兵马俑上竟然留存了制作者的指纹:

考古人员通过超景深显微镜捕捉到了2000多年前清晰的指纹印记,提取了指纹100多枚。这些穿越时空的“指尖密码”,不仅让后人触及到秦代工匠的远古技法,更揭示出一个事实——兵马俑的塑造者中,竟有未成年人。

2025-07-30 15:17:51

再次感叹:K2的Agentic能力太强了

2025-07-30 16:06:49

雨天在家细读:https://manus.im/zh-cn/blog/Context-Engineering-for-AI-Agents-Lessons-from-Building-Manus

2025-07-30 22:24:19

ETH十周年。

2025-07-31 11:01:48

ollama有GUI了

8月

2025-08-02 00:10:57

Crew-11成功!

2025-08-06 10:07:43

世运会首个比赛日已经开启

2025-08-06 10:30:17

开源模型胜利了

2025-08-06 11:16:26

https://gpt-oss.com/

2025-08-06 15:25:36

把Ollama的gpt-oss加载到GPU:

curl http://localhost:11434/api/generate ^

-d “{\”model\”:\”gpt-oss:20b\”,\”keep_alive\”:\”5m\”,\”options\”:{\”num_gpu\”:99},\”prompt\”:\”\”,\”stream\”:false}”

立即卸载模型:

curl http://localhost:11434/api/generate -d “{\”model\”:\”gpt-oss:20b\”,\”keep_alive\”:0}”

2025-08-07 09:44:44

OpenAI预告了GPT-5将于明天凌晨发布。

2025-08-08 09:26:57

GPT-5在所有领域都进步了一点点

2025-08-08 11:48:44

https://www.kaggle.com/benchmarks/kaggle/chess-text/tournament

最终o3拿下了冠军

2025-08-10 01:45:30

赤藓糖醇的回甘时间也太长了

2025-08-11 01:08:53

美国在线(AOL,现隶属于雅虎旗下)宣布将于 2025 年 9 月 30 日正式停止其基于公共交换电话网络(PSTN)的拨号上网服务,结束其长达 34 年的运营历史。

2025-08-11 17:08:12

Claude Code对token使用的计量还挺准的

2025-08-13 11:21:48

蘇姿丰和黃仁勳是遠房親戚。蘇姿丰的外公和黃仁勳的母親是兄妹,因此蘇姿丰要喊黃仁勳一聲「表舅」。

2025-08-13 16:54:54

这周又是日期数字的个位数与星期几对应的一周。

2025-08-15 08:54:14

凌晨看展新体验get

2025-08-15 08:54:49

在视频号刷到金味麦片,戳中一个小时候的回忆

2025-08-18 13:38:50

继王自如之后,罗永浩也开视频播客了

2025-08-19 11:03:12

千问Qwen直接把万相Wan的事情都干了

2025-08-22 11:41:12

AutoGLM大半年后拿出的方案是云手机+云电脑。云手机背后是华为云的云手机服务,云电脑背后是阿里云的无影。

2025-08-25 10:36:52

有些产品的AI助手,还在用2023年的模型,一问就感觉不如小学生。对,说的就是supabase

2025-08-27 15:12:38

nano banana对接好了

2025-08-29 11:05:33

很多东西变了,但很多东西也没有变。

9月

2025-09-01 10:00:52

iOS 26动效的增加,导致部分UI的响应时间有延迟

2025-09-01 12:06:59

Notion邮箱,实际上是Gmail的又一个客户端,但加载速度好快啊!

2025-09-03 09:58:02

印象中这是第五次看阅兵了

2025-09-03 13:32:42

东风-5C “打击范围覆盖全球”,这个应该是轨道级飞行。

2025-09-04 12:09:29

https://developer.apple.com/cn/videos/design/

2025-09-06 13:26:29

隔了几个月再看元宝客户端,非常好,产品交互和体验在国内完全对齐ChatGPT,简洁派表示舒适,豆包太花哨了

2025-09-07 15:01:16

霍炬的观点可能是真相,就是Anthropic并不是反华,而是反开源。因为目前头部的开源模型几乎都来自中国。

2025-09-08 14:11:57

Agent,会根据大模型在外部操作的结果来执行下一步,这会影响模型以外的虚拟世界。

2025-09-09 10:28:54

现在最强的生图模型和生视频模型都出自Google了

2025-09-10 11:36:57

国行页面继续标注“为Apple智能预备好”,年底前应该可以上了吧

2025-09-11 10:12:39

国行AirPods Pro 3硬件上与海外版本是一样的。

2025-09-12 12:50:46

姚顺雨的名字跟尧舜禹谐音 :0080:

2025-09-14 18:05:46

香蕉是一种攻击性很强的水果,你可以在搅拌机里加入15种水果,但要是加入1根香蕉,那它就是香蕉奶昔。

2025-09-14 20:36:36

窗外是蓝星 蓝星是我们的蓝色星球 地球

2025-09-16 10:42:21

西贝的自杀式直播,暴露了贾国龙完全不熟悉基层情况。

2025-09-16 16:38:08

成都明天再开两条地铁,武侯祠终于有地铁直达了

2025-09-17 10:55:04

https://www.volcengine.com/experience/ark?launch=seedream

2025-09-17 14:40:37

「電話」與 FaceTime 中的「即時翻譯」功能可在一對一通話時使用,適用於已啟用 Apple Intelligence 的相容 iPhone、iPad 或 Mac;支援英文 (英國、美國)、法文 (法國)、德文 (德國)、葡萄牙文 (巴西) 與西班牙文 (西班牙)。今年稍晚,iPhone 和 FaceTime 的「即時翻譯」功能將新增支援以下語言:簡體中文、繁體中文 (華語)、義大利文、日文、韓文。

2025-09-20 18:06:06

ChatGPT会话的分享链接发给别人后,别人还能继续接着聊。这个逻辑挺有意思的。

2025-09-23 11:09:20

https://lmarena.ai/leaderboard/image-edit

2025-09-24 11:17:45

有点感动是怎么回事

经典模式回归:腾讯 QQ 发布 Windows 9.9.22、macOS 6.7.81 版本更新,支持合并独立聊天窗口 https://www.ithome.com/0/885/281.htm

2025-09-26 18:05:10

我永远都是行动派。

2025-09-28 10:50:28

Kimi的OK Computer很不错

2025-09-30 10:27:25

https://www.anthropic.com/news/claude-sonnet-4-5

2025-09-30 11:13:34

趁evus收费之前更新了一下

10月

2025-10-01 17:46:46

Sora 2终于不是期货了 也不是Pro Plan专属 发布就能免费玩上

2025-10-03 14:31:55

我才发现iOS 26上的高光可以随着手机摆动而移动……

2025-10-04 18:08:22

新的RAG:让模型智能自主决策到哪个文件去查找所需信息

2025-10-04 19:09:54

iOS26本地传输数据竟然恢复不了已下架的app……

2025-10-09 13:42:17

浦东美术馆 抓个尾巴

2025-10-13 16:36:10

liblib的国内产品直接提供了nano/mj/gpt-image-1等模型,还挂着网信算法备案号和生成式人工智能服务备案号……

2025-10-14 11:10:52

鸿蒙端微信大版本号从1.0跳到8.0了,大部分功能跟iOS和安卓已对齐。

2025-10-14 18:29:43

俄罗斯禁了所有漫游到俄罗斯境内的海外sim卡联网

2025-10-15 10:59:21

招行和shadowrocket的app都换成液态玻璃tabbar了

2025-10-15 11:02:46

这个赛季,开拓者要成主队了……

2025-10-15 14:12:55

Apple Intelligence已开启功能:

本地:Siri基础问题、相册擦除、通知中心总结/首要通知、写作工具、同传翻译

联网:ChatGPT扩展、视觉智能、图乐园、智绘表情

2025-10-17 17:31:38

单扬单摄之外,C1X基带的iPhone Air支持5G-A

2025-10-20 23:26:54

《许我耀眼》赵露思穿搭合集:https://nutllwhy.github.io/xuwoyaoyan/

2025-10-22 11:17:49

Siri最大的问题是中文普通话的语音识别不准

2025-10-23 13:59:49

A19 Pro + C1X有点厉害啊

2025-10-23 16:01:17

从完整度来说,Comet导入Chrome也太彻底了,扩展、历史记录、连登录态都保留了…… Atlas学学

2025-10-27 15:38:59

用了5天,iPhone Air 真的还挺神奇的。

手感太轻太薄了,像拿着一片玻璃,但感觉又很结实。相比之下S25 edge并没有这种感觉,还是挺厚的。

有时候看着侧面在想,屏幕/电池/magsafe/背面板叠在一起居然只有5.6mm,好不真实。不像是现在这个时代能做出来的东西。

电池在导完数据的前两天耗电较快,这两天已经恢复正常,比mini系列的续航好太多,C1X应该功不可没。

可能就是高刷屏、超薄电池、背面超瓷晶面板,还有 C1X 基带能效、eSIM这些技术都成熟了,才能造出这样的设备吧。

2025-10-27 16:55:19

美区Apple Music竟然可以导入Spotify歌单(通过songshift的服务

11月

2025-11-04 11:33:38

微信把个人视频号入口改成了“视频号与公众号”,将公众号发布入口也放进去了

2025-11-04 11:34:28

Alpha Arena Season 1 is now over, as of Nov 3rd, 2025 5 p.m. EST

Season 1.5 coming soon

2025-11-06 08:55:13

乐播投屏太流氓了,还是用Apple TV投屏吧

2025-11-06 11:47:55

非常需要微信会话分组功能。

2025-11-08 11:01:13

AirPods Pro 3的重置改成了正面触控双击

2025-11-11 18:15:27

https://trustmrr.com/game 有点意思

2025-11-13 12:01:19

全运会没有奖牌榜了,各地还是会自己发布

2025-11-14 10:25:50

从Timenerd、Raycast到Rewind到MineContext、Dayflow

2025-11-14 15:25:16

有很多好的开源项目,不通过社交媒体还很难自己发现。

2025-11-14 17:28:02

Steam Machine如果在5000元级还是很有竞争力的

2025-11-19 21:01:02

库拉索🇨🇼晋级世界杯决赛圈,之前还没听说过这个国家,查了一下是荷兰的附属王国。

2025-11-24 14:01:46

虽然已有预期,但依然被NanoBananaPro驱动的NotebookLM生成的信息图和PPT惊呆了

2025-11-26 13:22:48

ChatGPT想做小程序生态,内置应用程序,看来App Store的小程序内购分成政策适用微信也针对OpenAI

2025-11-28 10:20:19

Apple的很多初代产品,我都是尝鲜者:Apple Watch初代、AirPods初代、12寸MacBook初代、iPhone Air初代

12月

2025-12-01 10:57:48

#nowplaying 派对动物 – 五月天

2025-12-02 14:09:09

Gemini DeepResearch的思考过程现在会出现循环

2025-12-03 10:40:44

豆包手机是中兴nubia M153工程机,现在在这款手机登录微信,会被微信提示风险强制退出……

2025-12-03 11:51:46

今年王自如和罗永浩都回归科技数码圈了

2025-12-04 18:32:59

系统叫Obric UI,系统账号是豆包账号,内置有云服务(与欢喜云的同步项相同)和应用商店。

2025-12-07 11:09:22

《电脑爱好者》9月24日停止更新,12月6日正式注销。

2025-12-10 10:38:19

豆包手机在交互上的重大创新我觉得有两点:

1、PhoneUse操作手机在后台实现,且在后台也支持跨应用操作,不占用前台任务,相比云端实现又能拥有完整context,同时在隐私上也与当前屏幕内容隔离开;

2、可以设置定时重复任务,实现固定工作流,大大提高灵活性和实用性,虽然目前最多只能设置5个任务。

2025-12-11 15:27:56

记忆突然被拉回20年前

2025-12-11 18:58:41

type1决策:做了就不能回头;

type2决策:做错了还能重新尝试;

很多人都把type2决策当成type1,不敢去试错。

2025-12-12 11:19:48

OpenAI都十岁了。

2025-12-15 17:11:16

https://openrouter.ai/state-of-ai

2025-12-16 13:19:32

aistudio和灵光带来的趋势非常明显,明年基本上可以实现要啥工具现生成。

2025-12-16 16:02:50

国产信创生态还需要降低软硬件成本,信创服务器这么贵

2025-12-18 16:44:18

Gemini 3 Flash真的做到了又快又好……

2025-12-21 11:55:14

#FForever Fantasy4ever

2025-12-22 14:36:31

4年的电脑报合订本,清晰展现了AI时代的发展变化

2025-12-22 23:28:53

12月22日,中国国际广播电台劲曲调频广播频率HitFM(北京地区FM88.7和上海地区FM87.9)与轻松调频EzFM(北京地区FM91.5、重庆市FM89.8、西藏自治区拉萨市FM100.0)正式官宣,将于12月23日0时起停播。

2025-12-23 16:24:59

快手这次没有出现系统层面的入侵,是接码批量注册+内容安全的绕过……

2025-12-23 17:06:50

在语音输入的准确度接近100%的时候,就会很愿意使用了,比手打快很多。

2025-12-23 18:07:22

今年ChatGPT的使用被Gemini分走了很多

2025-12-24 20:51:36

在Cursor里用的ClaudeCode就没统计了

2025-12-26 13:10:17

TRAE的国内版,因为下半年国产基座模型的提升,现在也基本可用了

2025-12-28 09:16:43

10年以上俱乐部:小红书、豆瓣、微信读书、网易云音乐、QQ音乐

2025-12-28 10:25:33

“ALICE线”(ALICE Threshold)

ALICE是“Asset Limited,Income Constrained,Employed”的缩写,即“资产有限、收入有限、有工作”,它代表着美国收入高于联邦贫困线但经济不安全的家庭。

2025-12-29 11:57:44

在HarmonyOS能用tooot,但iOS却没有了……

2025-12-29 16:51:00

https://claude.com/blog/skills-explained

2025-12-29 19:04:38

智谱的AI输入法,界面都跟Typeless差不多,快捷键也一样……

2025-12-30 09:18:20

中国AI创业者的高光时刻 恭喜Manus!

2025-12-30 14:23:08

商业竞争就是这么朴素😂

2025-12-31 09:46:59

香港《亚洲周刊》因报道南博事件中庞家人的发声而被封禁微博/微信公众号。

2025-12-31 16:58:27

Typeless的asr成精了

2025-12-31 23:45:12

今年的生产力时间用在了这些软件上:Cursor/Trae/Codebuddy/Kiro/Antigravity(辗转薅Claude🫣

2026-01-02 12:07:48

突然觉得2026是一个很未来的年份

2026-01-02 17:53:38

我的 #2025年度产品:

iPhone Air

Google AI Studio Build Mode

Gemini App

豆包输入法 + Typeless

TRAE + Claude Code

Manus

Lovart

ClashVerge

SpeedPush

Voodle

2026-01-02 18:12:31

今年增加一个我的 #2025年度AI模型:

DeepSeek-R1

Gemini 3.0 Flash

Gemini 3.0 Pro Image

GPT-5.2

Claude Opus 4.5

Qwen3

Kimi-K2-Thinking

GLM-4.7

MiniMax-M2.1

Seedream 4.5